هر آنچه در مورد هوش مصنوعی

هوش مصنوعی، هوشی است که توسط دستگاهها ارائه می گردد. در علم کامپیوتر دستگاه هوشمند یک عامل عقلانی (Rational agent) انعطاف پذیر است که محیط اطرافش را درک کرده و برای افزایش احتمال موفقیت در اهداف تعیین شده، اقداماتی را انجام می دهد.

به طور عامیانه واژه “هوش مصنوعی” زمانی به کار برده می شود که یک دستگاه از “عملکردهای شناختی” که طی آن انسانها از اندیشه ها و افکار دیگر انسانها بهره می گیرند، تقلید کند، عملکرد های شناختی همچون؛ یادگیری و حل مشکلات.

امروزه هر چه دستگاهها توانمندتر می شوند، اندیشه سابق هوشمند کردن آنها دیگر بی معنی می شود. بعنوان مثال هر چند که “تشخیص نوری کاراکتر” مدت زیادی نیست که به عنوان هوش مصنوعی شناخته شده است، امروزه به یک تکنولوژی روتین تبدیل شده است. توانایی هایی که هنوز هم به عنوان هوش مصنوعی در نظر گرفته می شوند عبارتند از؛ بازی شطرنج پیشرفته، سیستم های بازی “گو” و خودروهای بدون راننده.

پژوهش های هوش مصنوعی به زیر شاخه هایی تقسیم می شوند که تمرکز آنها؛ بر مشکلات خاص، رهیافت های دقیق، استفاده از ابزارهای خاص و یا برآوردن کاربردهای خاص می باشد.

عمده چالش های (اهداف) هوش مصنوعی عبارتند از: استدلال، دانش، برنامه ریزی، یادگیری، پردازش زبان ذاتی(ارتباط)، درک و توانایی حرکت و به کارگیری ماهرانه ی اشیاء است.

هوش مصنوعی عمومی (هوشی که دستگاه را به انجام کار ذهنی، آنگونه که بشر قادر به انجام آن است، توانمند سازد) از جمله اهداف دراز مدت است. رهیافت ها شامل: روش های آماری، هوش محاسباتی، محاسبات نرم (مانند یادگیری ماشینی) و سنت نمادین هوش مصنوعی هستند. ابزارهای بسیاری در هوش مصنوعی به کار گرفته شده اند که انواع تحقیق و بهینه سازی ریاضی، منطق، شیوه های مبتنی بر احتمال و اقتصاد را احاطه کرده است.

رشته هوش مصنوعی از علم کامپیوتر، ریاضیات، روانشناسی، زبان شناسی، فلسفه، عصب شناسی و روانشناسی مصنوعی بهره می برد.

هوش مصنوعی بر این ادعا پایه ریزی شده است که میتوان هوش انسانی را جزء به جزء ترسیم کرده و دستگاهی برای تقلید از آن ساخت. این مطلب بحث و جدل های فلسفی در مورد ذات ذهن و اخلاقیات موجود مصنوعی بهره مند شده از هوش شبه انسانی، را بالا برده است، مسائلی که از عصر باستان در افسانه ها، خیالات و فلسفه مطرح شده بود.

تلاش ها برای خلق هوش مصنوعی عقب نشینی های زیادی را تجربه کرده است، از جمله گزارش ALPAC(کمیته مشورتی پردازش زبان اتوماتیک) در سال 1966، دست کشیدن از پرسپترون (یک نوع شبکه عصبی مصنوعی) در سال 1970، گزارش لایتیل در سال 1973 و نیز اقدامی تحت عنوان “Collapse of the Lisp machine market” .

تاریخچه هوش مصنوعی

زمانیکه در عصر باستان مفهوم موجود مصنوعی (چیزی که قادر به فکر کردن باشد) بعنوان یک ابزار داستان سرایی شناخته شده بود، ایده تلاش برای ساخت ماشینی که تفکر سودمند انجام دهد توسط “رامون لیول” (حدود سال 1300 میلادی) ارائه گردید.

نخستین ماشین حساب در سال 1623 میلادی توسط دانشمندی به نام “ویلهم شیکارد” ساخته شد. “گوتفرید لایب نیتس” نسخه ای به اصطلاح ناپخته از موجود مصنوعی را ساخت که گرایش این ماشین به اجرای عملیات مفهومی بیشتر از عملیات اعداد بود. از قرن نوزدهم میلادی موجودات مصنوعی در افسانه ها رواج یافتند؛ رمان “فرانکشتاین” خانم “مری شلی” و یا آدم های ماشینی “کارل چاپک”. استدلال مکانیکی یا صوری، توسط فلاسفه و ریاضیدانان در عصر باستان مطرح شد. در قرن نوزدهم “جرج بول” اندیشه های پیشین را به “منطق گزاره ای” اصلاح کرده و “گوتلوب فرگر” یک سیستم نت برداری برای استدلال ماشینی توسعه داد (یک حساب گزاره ای).

در دهه 1940، نظریه محاسبات “آلن تورینگ” بیان کرد که یک ماشین با چینش نمادهایی ساده هم چون “0” و “1” می تواند هر عمل ممکن در استنتاج ریاضی را انجام دهد.

این اندیشه که کامپیوترهای دیجیتال قادر به تقلید هرگونه استدلال صوری هستند، به عنوان فرضیه”چرچ تورینگ” شناخته شد. پیشرفتها در علم عصب شناسی (نظریه اطلاعات و سایبرنتیک)، دانشمندان را به تأمل در مورد امکان ساخت مغز الکترونیکی وا داشت. نخستین اقدامی که عموماً امروزه به عنوان هوش مصنوعی شناخته می شود طرح “مک کولو” و “پیت” برای عصب مصنوعی “تورینگ کامل”بود.

رشته تحقیق در هوش مصنوعی سال 1956 در کالج دارتموث بنیان نهاده شد. جان مک کارتی، ماروین متیسکی، آلن نِوِل، آرتور ساموئل و هربرت سیمون به این رشته گرویده و از پیشگامان تحقیقات در هوش مصنوعی شدند. آنها به همراه دانشجویان خود، برنامه هایی را نوشتند که مایه بهت و حیرت عامه مردم بود؛ کاربرد کامپیوترها در نقش مأمور کنترل چی، حل مشکل کلمات در جبر، اثبات نظریات استدلالی و سخن گفتن به زبان انگلیسی از جمله موفقیت های این گروه بود.

در اوسط دهه 1960 میلادی پژوهش های بسیاری در دپارتمان دفاع ایالات متحده پایه ریزی شده و آزمایشگاه های بسیاری در سرتاسر جهان تأسیس گردید. بنیانگذران هوش مصنوعی به آینده امیدوار بودند. “هربرت سیمون” پیش بینی کرد، ماشین ها در عرض 20 سال خواهند توانست هر کاری که بشر قادر به انجام آن هست را انجام دهند. “ماروین مینسکی” نیز موافق این پیش بینی بود و نوشت: در طی یک نسل . . . مشکل ایجاد هوش مصنوعی به طور کامل حل خواهد شد. آنها از تشخیص برخی مشکلات باقیمانده عاجز بودند.

در سال 1974 از سرعت پیشرفتها کاسته شد. در واکنش به انتقاد “جیمز لایتیل” و نیز فشار از جانب کنگره ایالات متحده برای سرمایه گذاری در پروژه های پر بازده، دولت های ایالات متحده و انگلستان تحقیقات در زمینه هوش مصنوعی را متوقف ساختند. این سالها به عنوان “زمستان هوش مصنوعی” شناخته شد، دوره ای که سرمایه گذاری روی پروژه های هوش مصنوعی بسیار کم شد.

در اوایل دهه 1980 با موفقیت های اقتصادی “سامانه های خبره”(Expert systems) تحقیقات هوش مصنوعی دوباره احیاء شد. “سامانه های خبره” یک برنامه هوش مصنوعی بود که از دانش و مهارتهای آنالیزی افراد متخصص تقلید می کرد. در سال 1985 بازار هوش مصنوعی به ارزشی بیش از یک میلیارد دلار دست یافت. در همین سال پروژه کامپیوترهای نسل پنجم ژاپن موجب شد تا دولت های ایالات متحده و انگلستان مجدداً اقدام به سرمایه گذاری در تحقیقات آکادمیک کنند. این آغاز با جمع شدن بازار ماشین های لیسپ در سال 1987 همراه شده و دوباره هوش مصنوعی دچار یک بی اعتباری شد و وقفه دوم که طولانی تر نیز بود، آغاز گردید.

در اواخر دهه 1990 و اوایل قرن 21 هوش مصنوعی در لجستیک، کاوش اطلاعات، تشخیص پزشکی و دیگر زمینه ها به کار گرفته شد. موفقیت ها بخاطر؛ افزایش توان محاسباتی(قانون مور)، تأکید بیشتر بر حل مشکلات خاص، پیوند جدید بین هوش مصنوعی و دیگر زمینه ها و نیز التزام دانشمندان به روش های ریاضی و استانداردهای علمی بود. “دیپ بلو” نخستین سیستم کامپیوتری بازی شطرنج بود که توانست قهرمان دنیا “گری کاسپاروف” را در یازدهم مِی 1997 شکست دهد.

تکنیک های پیشرفته آماری (به عنوان “یادگیری عمیق” نیز شناخته شده است) به حجم زیادی از اطلاعات و کامپیوترهای پر سرعت دسترسی یافته و موجب توانمندی بیشتر در “یادگیری ماشین” و استنباط شده اند. در اواسط دهه 2010 اپلیکیشن های یادگیری ماشین در سرتاسر جهان مورد استفاده قرار گرفت. در مسابقه تلویزیونی پرسش و پاسخ “جئوپاردی” سامانه پاسخگوی شرکت IBM به نام واتسون توانست دو قهرمان جئوپاردی به نام های “براد راتر” و “کن جنینگز” را با اختلاف قابل توجهی شکست دهد. “کینکت” که واسطه حرکت 3 بعدی بدن را برای ایکس باکس 360 وایکس باکس وان فراهم می کند، همانند دستیارهای شخصی هوشمند در اسمارت فون ها از الگوریتم هایی بهره می گیرند که حاصل تحقیقات دراز مدت هوش مصنوعی است. در مارس 2016 “آلفاگو” 4 بازی از 5 بازی “گو” با قهرمان بازی های گو “لی شدول” را برد و به عنوان نخستین سیستم کامپیوتری بازی گو توانست بدون آوانس بازیکن حرفه ای گو را شکست دهد.

تحقیقات هوش مصنوعی

اهداف هوش مصنوعی

عمده مشکل تقلید (یا ایجاد) هوش به زیر موضوعاتی تفکیک می گردد. این مسائل عبارتند از: خصوصیات یا توانایی هایی که محققان از هوش مصنوعی انتظار نمود آن را دارند. خصوصیاتی که در زیر شرح داده شده است بیشترین توجه را به خود جلب کرده اند.

استنتاج، استدلال، حل مشکل

اولین محققان الگوریتم هایی را توسعه دادند که قدم به قدم از استدلالی تقلید می کردکه انسان هنگام حل معما یا نتیجه گیری منطقی از آن بهره می برد. در اوخر دهه 1980 و دهه 1990 تحقیقات هوش مصنوعی با بکارگیری مفاهیمی از احتمال و اقتصاد روش هایی را برای عدم قطعیت (اطلاعات ناقص) توسعه داد.

برای مسائل مشکل، الگوریتم ها نیازمند منابع عظیم محاسباتی هستند. بیشترین احتمال بروز یک “انفجار ترکیبی”(موقعیتی که به هنگام حل مسئله اتفاق می افتد) موقعیست که: میزان حافظه یا زمانیکه کامپیوتر برای مسائلی با اندازه معین بدان نیازمند است به طور نجومی افزایش یابد. کاوش برای الگوریتم های مفید حل کننده مشکلات یک اولویت مهم و اساسی است.

به طورمعمول بشر سریع استفاده می کند، پنداشت ذاتی به جای استدلال مرحله ای که تحقیقات اولیه هوش مصنوعی قادر به مدلسازی آن بود. هوش مصنوعی با استفاده از زبان “sub-symbolic” در حل مسائل پیشرفت کرده است: رهیافت های “عامل گنجانده” (embodied agent) بر اهمیت مهارتهای موتور حسی جهت استدلال عالی و مبتکرانه تر تاکید می کنند؛ تحقیقات شبکه عصبی جهت تقلید از ساختار درونی مغز برای بالا بردن این مهارت در تلاش است؛ روش های آماری در هوش مصنوعی از توانایی تفکر انسانی تقلید می کنند.

تظاهر دانش در هوش مصنوعی

اونتولوژی دانش را بعنوان مجموعه ای از مفاهیم در حصار یک دامنه و روابط بین این مفاهیم را نشان میدهد.

تظاهر دانش و مهندسی دانش در تحقیقات هوش مصنوعی از مرکزیت برخوردار هستند. بیشتر مسائلی که انتظار می رود ماشین ها آنها را حل کنند، نیازمند دانشی فراگیر در مورد جهان خواهند بود. از جمله مواردی که هوش مصنوعی برای تظاهر بدان نیازمند است عبارتند از: اشیاء، ویژگی ها، دسته ها و روابط بین اشیاء؛ موقعیت، پیشامدها، چگونگی و زمان؛ دلایل و اثرات؛ دانش در مورد دانش(آنچه که ما از دانسته های دیگر مردم می دانیم)؛ و بسیاری از موارد دیگر، که این دامنه ها به خوبی تحقیق و بررسی نشده اند. یک نمود از “آنچه که موجود است” اونتولوژی می باشد: مجموعه ای از اشیاء، روابط و مفاهیم و غیره که ماشین در مورد آنها اطلاع دارد. آنچه که بیشتر معروف به اونتولوژی بالادست(upper ontology) است، در تلاش برای ایجاد یک اساس برای دیگر دانش هاست.

از جمله مشکل ترین مسائل در تظاهر دانش عبارتند از:

استدلال پیش فرض و مسئله شایستگی در هوش مصنوعی

بیشتر چیزهایی که مردم می دانند فرم ” پنداشت کاری” (working assumption)گرفته است. به عنوان مثال اگر یک پرنده در گفت و گوی ظاهر شود مردم نوعاً حیوانی را تصویر می کنند که به اندازه یک مشت است، می خواند و پرواز می کند. هیچ یک از این موارد در مورد تمام پرنده ها صادق نیست. جان مک کارتی این مسئله را به عنوان مسئله شایستگی (qualification problem) در سال 1969 میلادی تشخیص داد: برای هر قاعده درک عام که محققان هوش مصنوعی علاقه به تظاهر آن دارند، گرایش به داشتن استثنائات بسیار است. در روش منطق مطلق هیچ چیز به سادگی درست یا غلط تلقی نمی گردد. تحقیقات هوش مصنوعی راه حل هایی برای این مشکل یافته اند.

وسعت نظر دانش “درک عامه” در هوش مصنوعی

حقایق اتمی که یک شخص عادی می داند بسیار زیاد است. پروژه های تحقیقاتی که در تلاش برای ساخت پایه و اساس “دانش درک عامه” هستند، به حجم زیادی از مهندسی اونتولوژی دشوار نیاز دارند، این پایه و اساس بایستی با دست ساخته شوند که مفهومی پیچیده در یک مقطع زمانی است. هدف اصلی، داشتن کامپیوتری است که به قدر کافی مفاهیم را درک کند تا بتواند با خوانش از منابعی همچون اینترنت به اونتولوژی (موجودیت) خود بیفزاید.

فرم sub-symbolic دانش “درک عامه“

بیشتر معلوماتی که مردم دارند نمود “حقیقی” یا “بیانی” که بتوان آنها را بصورت لغوی بیان کرد، ندارند. برای مثال یک شطرنج باز ماهر، از قرار دادن یک مهره در یک وضعیت خاص پرهیز می کند زیرا احساس می کند که این کار خطرناک است و یا یک کارشناس و منتقد هنری با نگاه کردن به یک مجسمه و یا یک نقاشی تشخیص می دهد که آن جعلی و تقلبی است. چنین مواردی ادراک و استعدادهایی هستندکه به صورت ناخودآگاه و ساب سمبولیکی در مغز تظاهر پیدا می کنند. این نوع دانش تقویت کننده و ایجاد کننده مفهوم برای زبان سمبولیک در دانش آگاهانه است. امید است رهیافت هوش مصنوعی جایگزین (Situated AI) ، هوش محاسباتی و یا هوش مصنوعی آماری راههای را برای نمود این نوع دانش در گیر و دار مسئله استدلال ساب سمبولیک فراهم آورد.

طراحی در هوش مصنوعی

“سیستم کنترل سلسله مراتبی” نوعی سیستم کنترل است که مجموعه ای از دستگاهها و نرم افزارهای مدیریتی طی یک سری سلسله مراتب در آن چیده شده است.

عوامل هوشمند بایستی قادر به هدف گذاری و نیل به آنها باشند. آنها به راهی برای تصور کردن آینده نیاز دارند ( بایستی یک تصور از وضعیت اطراف داشته و قادر به پیش بینی عملکرد خود جهت تغییر دادن اوضاع باشند) و قادر به انتخاب های سودمند (یا با ارزش) از میان موارد انتخابی باشند.

در طراحی کلاسیک مسائل، عامل (هوشمند) می توانست چنین فرض کند که تنها موجود عمل کننده در دنیا بوده و با قطعیت نتیجه عملکردش را می داند. اما اگر عامل تنها عمل کننده نباشد، بایستی در فواصل معینی معلوم کند که آیا دنیای اطراف آن با پیش بینی هایش هم خوانی دارد، و هر جا لازم بود برنامه خود را تغییر دهد که این نیازمند استدلال عامل در شرایط عدم قطعیت است.

“طراحی چند عاملی” (Multi-agent planing) از همکاری و رقابت چندین عامل برای رسیدن به هدف استفاده می کند. ظهور یافتگی(فرایندی است که طی آن اجزا کوچک تر و یا ساده تر طی تعاملاتشان با هم، اجزا بزرگتر و یا پیچیده تری را می سازند که خواص اجزا ساده تر را ندارد) در الگوریتم های تکاملی و هوش ازدحامی (swarm intelligence) به کار گرفته شده است.

یادگیری در هوش مصنوعی

یادگیری ماشینی مطالعه الگوریتم های کامپیوتریست، که به صورت خودکار و از طریق کسب تجربه پیشرفت کرده و از آغاز این رشته در تحقیقات هوش مصنوعی از مرکزیت برخوردار است.

یادگیری بی نظارت (unsupervised learning) توانایی پیدا کردن الگوها در جریان ورودیست که هم طبقه بندی و هم رگرسیون عددی را شامل می شود. طبقه بندی پس از مشاهده تعدادی از نمونه های دسته ها تعیین میکند که چه چیزی به کدام دسته متعلق است. رگرسیون تلاش برای ایجاد عملکردیست که رابطه بین داده ها و خروجی ها را توصیف کرده و چگونگی تغییر خروجی ها با تغییر داده ها را پیش بینی کند. در یادگیری تقویتی (reinforcement learning) عامل هوشمند برای عکس العمل های خوب جایزه گرفته و برای اجراهای نامطلوب تنبیه می شود. عامل هوشمند از ترتیب پاداش ها و تنبیه ها استفاده می کند تا یک استراتژی برای اجرا در فضای مسئله ایجاد کند. این سه نوع یادگیری با بهره گیری از مفاهیمی همچون “سودمندی” می توانند تحت عنوان “نظریه تصمیم گیری” مورد آنالیز قرار گیرند. آنالیز ریاضیاتی الگوریتم های یادگیری ماشینی و عملکرد آنها شاخه ای از علم تئوریک کامپیوتر است که به عنوان تئوری “یادگیری محاسباتی” شناخته می شود.

در خلال توسعه رباتیک، برای یادگیری مهارتهای جدید توسط ربات، روش های پیشرفته یادگیری ابداع شده اند. یادگیری مهارتهای جدید از طریق خودیابی (self-exploration) و روابط اجتماعی با آموزگاران انسانی و نیز استفاده از مکانیسم های هدایتگری همچون؛ یادگیری فعال، رشد و بلوغ، همیاری موتوری و تقلید انجام گرفته است.

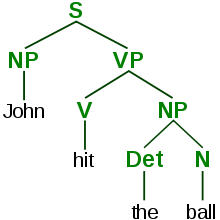

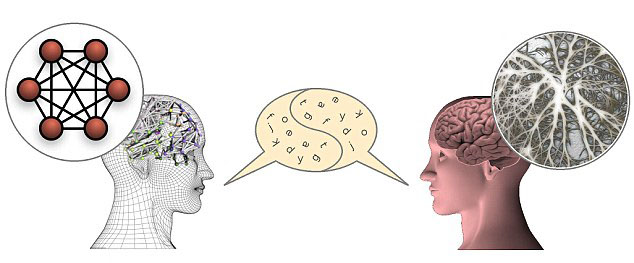

فرآیند زبان ذاتی (ارتباط) در هوش مصنوعی

درخت تجزیه ساختار نحوی جمله بر اساس دستور زبان صوری را نشان می دهد.

پردازش زبان طبیعی (Natural language processing) به دستگاهها امکان بازخواندن و درک زبان انسانی را می دهد. یک سیستم قدرتمند و کارای پردازش زبان طبیعی، “واسط کاربری زبان طبیعی” (natural language user interfaces) را قدرتمند ساخته و یادگیری مستقیم دانش از منابع نوشتاری انسانی (مانند روزنامه) را ممکن می سازد. برخی از کاربردهای ساده پردازش زبان طبیعی عبارتند از: بازیابی اطلاعات، متن کاوی (استخراج اطلاعات با کیفیت از متن)، پاسخ دهی و ترجمه ماشینی.

روش معمول پردازش و استخراج مفهوم از زبان طبیعی از طریق “نمایه سازی معنایی” است. افزایش سرعت پردازش و کاهش هزینه نگهداری اطلاعات نمایه سازی حجم بالایی از داده های کاربر را بسیار کارآتر انجام می دهد.

درک در هوش مصنوعی

مقالات اصلی: درک ماشین، بینایی کامپیوتری، و بازشناسی گفتار

درک ماشینی توانایی استفاده از داده های سنسورها (از جمله: دوربین ها، میکروفون ها، حسگرهای لمسی، ردیاب آوایی و دیگر سنسورهای کم نظیر) برای ترسیم دنیاست. بینایی یارانه ای توانایی آنالیز داده های بصریست. چند مشکل برجسته در زمینه درک در تشخیص گفتار، تشخیص چهره و تشخیص شیء وجود دارد.

حرکت و مهارت در هوش مصنوعی

رشته روباتیک در ارتباط نزدیک با هوش مصنوعی می باشد. روباتها برای انجام کارهایی همچون کنترل یا استفاده ماهرانه از یک شئ و ناوبری نیازمند هوش هستند. انجام این کارها با مسائل؛ مکان یابی (دانستن اینکه شما کجا هستید، یا دیگر چیزها کجا هستند)، نقشه یابی (درک آنچه که اطراف شماست و ایجاد نقشه محیط) و برنامه ریزی حرکتی ( تشخیص چگونگی رسیدن به آنجا) یا برنامه ریزی مسیر(رفتن از یک جا به جای دیگر، که ممکن است در جایی که ارتباط فیزیکی با یک شئ دارد، حرکت تحت فرمان باشد) روبروست.

اهداف بلند مدت در هوش مصنوعی

اهداف بلند مدت هوش مصنوعی عبارتند از: هوش اجتماعی، خلاقیت و هوش عمومی.

هوش اجتماعی

کیسمت؛ رباتی با مهارتهای اجتماعی اولیه

“محاسبه مؤثر”، مطالعه و توسعه ی سیستم ها و دستگاههایی است که قادر به تشخیص، تفسیر، پردازش و تقلید عواطف انسانی باشند. رشته ای بین رشته ای در علوم کامپیوتر، روانشناسی و دانش شناختی است. در حالیکه ممکن است این علم از پرسش های پیشین فلسفه ای نسبت به احساسات، نشأت گرفته باشد، سال 1995شاخه ای مدرن از علم کامپیوتر در محاسبه مؤثر با مقاله “روزالین پیکارد” شکل گرفت. توانایی تقلید “همدلی” انگیزه ای برای تحقیقات این حوزه است. ماشین بایستی احساسات انسانی را تفسیر کرده و رفتار خود را با آنها تطبیق داده و در نهایت پاسخی مناسب برای آن ارائه دهد.

مهارتهای احساسی و اجتماعی دو نقش را برای عامل هوشمند ایفا می کنند. اول اینکه با دانستن حالات انگیزه ای و احساسی قادر به پیش بینی اعمال دیگران می باشد.( این مهارت عناصری از “نظریه بازی”، “نظریه تصمیم گیری” و نیز توانایی تقلید احساسات انسانی و مهارتهای ادراکی برای تشخیص احساسات را در بر می گیرد). علاوه بر این در تلاشی برای تسریع “تعامل انسان و کامپیوتر”، ماشین هوشمند ممکن است (احتمال آن ضعیف است) جهت تظاهر حساسیت به اعمال احساسی انسانی، قادر به ابراز احساسات باشد (اگرچه در حقیقت خود ماشین هوشمند آن را تجربه نمیکند).

خلاقیت در هوش مصنوعی

یکی از زیر رشته های هوش مصنوعی خلاقیت را هم از لحاظ نظری (از منظر فلسفه ای و فیزیولوژیکی) و هم از لحاظ عملی (از طریق پیاده سازی سیستم های خاص که خروجی هایی نوآور داشته و یا سیستم هایی که قادر به شناسایی و ارزیابی نوآوری هستند) مورد توجه قرار داده است.

هوش عمومی در هوش مصنوعی

مقالات اصلی: هوش مصنوعی عمومی، هوش مصنوعی کامل (AI-compelete)

بسیاری از محققان چنین می پندارند که نهایتاً تلاش های آنها با ترکیب تمامی مهارتهای ذکر شده و دست یافتن به تمامی مهارتهای انسانی یا اکثر آنها، منجر به ایجاد ماشینی با هوش عمومی خواهد شد (معروف به هوش مصنوعی قدرتمند). چند تن از محققان بر این باورند که برای انجام چنین پروژه ای نیاز به خصوصیات انسانی همچون هشیاری مصنوعی و مغز مصنوعی می باشد.

هوش عمومی راه حل بسیاری از مسائل ذکر شده است. بعنوان مثال برای انجام یک کار خاص مثل ترجمه ماشینی، ماشین بایستی به هر دو زبان هم بخواند و هم بنویسد (پردازش زبان طبیعی)، از استدلال نویسنده پیروی کند (منطق)، بداند که در مورد چه چیزی بحث شده است (دانش) و با وفاداری به اصل مطلب، منظور نویسنده را برساند (هوش اجتماعی). مسئله ای همچون ترجمه ماشینی به عنوان “هوش مصنوعی کامل” در نظر گرفته می شود. برای حل این مشکل، یک نفر بایستی تمام مشکلات را حل کند!

رهیافت ها در هوش مصنوعی

نظریه یا پارادایم واحدی برای هدایت تحقیقات هوش مصنوعی وجود ندارد. محققان در موارد زیادی اختلاف نظر دارند. سؤالاتی که مدت زمان طولانی بی پاسخ مانده اند: آیا هوش مصنوعی بایستی با مطالعه روانشناسی و عصب شناسی، هوش طبیعی را تقلید کند؟ یا بیولوژی انسانی همانند ارتباط بیولوژی پرندگان با مهندسی هوانوردی در ارتباط با تحقیقات هوش مصنوعی است؟ آیا رفتار هوشمندانه می تواند با اصول ساده و ظریف توصیف گردد (مثل منطق یا بهینه سازی)؟ یا به طور حیاتی نیاز به حل تعداد زیادی مشکلات نامرتبط است؟ آیا هوش می تواند مثل کلمات و عقاید با نمادهای تخصصی باز تولید شود؟ یا نیاز به پردازش “ساب سمبولیک” دارد؟ جان هوگلند، کسی که واژه “هوش مصنوعی قدیمی خوب” (GOFAI=Good Old-Fashioned Artificial Intelligence) را ایجاد کرد نیز چنین می پندارد که هوش مصنوعی بایستی کاملاً بعنوان هوش ساختگی و تصنعی مدّ نظر قرار گیرد، واژه ای که با محققان غیر مرتبط این رشته نیز خو گرفته است.

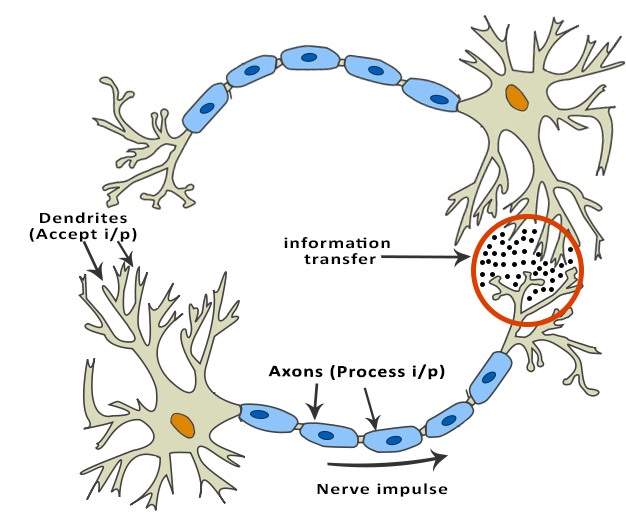

سایبرنتیک و شبیه سازی مغز در هوش مصنوعی

در دهه های 1940 و 1950، تعدادی از محققان ارتباط بین علم عصب شناسی، نظریه اطلاعات و سایبرنتیک را کشف کردند. برخی از آنها ماشین هایی را ساختند که با استفاده از شبکه های الکترونیکی هوش ابتدایی را نشان می داد، مثل روبات لاک پشت “ویلیام گری والتر” و روبات چهار پای “جان هاپکینز”. بسیاری از این محققان در جلسات “جامعه فرجام شناختی” (Teleological society) دانشگاه پرینستون و “مجمع ریشو” (Ratio club) انگلستان حضور یافتند. در سال 1960 این رهیافت بسیار شایع گردید، گرچه اصول آن در دهه 1980 جانی دوباره گرفت.

سمبلیک در هوش مصنوعی

زمانیکه دسترسی به کامپیوترهای دیجیتال در اوسط دهه 1950 ممکن شد، تحقیقات هوش مصنوعی شروع به بررسی احتمال تبدیل هوش انسانی به حرکات نمادین کرد. این تحقیقات با مرکزیت سه مؤسسه انجام گرفت: دانشگاه کارنگی ملون، استنفورد و MIT که هرکدام شیوه تحقیقاتی خود را پیش گرفتند. جان هوگلند این رهیافت ها برای هوش مصنوعی را “Good Old Fshioned AI” (به طور مخفف”GOFA”) نامید. در دهه 1960 رهیافت های سمبلیک به موفقیت های بزرگی در زمینه تقلید پیشرفته افکار در برنامه های کوتاه نمایشی دست یافتند.

در دهه 1960 میلادی برنامه های کوتاه نمایشی حاکی از موفقیت های بزرگ در زمینه پیاده سازی اندیشه های سطح بالا بود.

رهیافت های مبتنی بر سایبرنتیک یا شبکه های عصبی متداول گردیده و یا به عنوان زمینه تحقیقات قرار گرفته اند. محققان در دهه های 1960 و 1970 به این نتیجه رسیدند که رهیافت های سمبلیک نهایتاً موفق به خلق ماشینی با هوش مصنوعی عمومی خواهند شد و رسیدن به این هدف را زمینه تحقیقات خود قرار دادند.

تقلید شناختی در هوش مصنوعی

هربرت سیمون اقتصاد دان و آلن نول، مهارتهای انسان در حل مسئله را مورد مطالعه قرار داده و برای شکل دادن به آن تلاش کردند، که تلاش ها و اقدامات آنها پایه های رشته هوش مصنوعی و نیز علم شناختی، تحقیق در عملیات و علم مدیریت را ایجاد کرد. تیم تحقیقاتی آنها از نتایج آزمایشات روانشناسی برای توسعه برنامه هایی که از تکنیک های انسانی در حل مسائل استفاده می کردند، بهره گرفتند. این سنت در دانشگاه ملون کارنگی با توسعه Soar architecture در اواسط دهه 1980 به اوج خود رسید.

پایه ی منطق در هوش مصنوعی

برخلاف نول و سیمون، جان مک کارتی دریافت که ماشین ها به تقلید افکار انسانی نیاز ندارند و علی رغم آنکه مردم چگونه از الگوهای یکسان بهره می برند، به جای آن بایستی، به ذات استدلال انتزاعی و حل مسائل پی برده شود. آزمایشگاه جان مک کارتی در دانشگاه استنفورد بر استفاده از منطق صوری برای حل انواع گوناگون مسائل تمرکز کرد. مسائلی همچون: دانش، تظاهر، طراحی و یادگیری. علاوه بر این اقدامات دانشگاه ادینبورگ و نقاط دیگر اروپا که منجر به توسعه برنامه زبان “پرولاگ” و علم برنامه ریزی منطقی شد نیز دالّ بر کانون توجه قرار دادن منطق بود.

“غیر منطقی“ یا “ناهنجار” در هوش مصنوعی

محققان در MIT (مثل ماروین مینسکی و سیمور پَپِرت) پی به این مسئله بردند که حل مسائل مشکل در “بینایی کامپیوتر” و “پردازش زبان ذاتی” نیاز به راه حل های موردی (ad-hoc solutions) دارد. آنها چنین استدلال کردند که اساسی ساده و عمومی (مثل منطق) برای تصویر تمام نمادهای رفتار هوشمند وجود ندارد.

روگر شانک، رهیافت “غیر منطقی” آنها را “ناهنجار” توصیف کرد (چرا که با پارادایم های “مرتب”(neat) در CMU و استنفورد مخالفت می کرد). اساس دانش درک عامه (Commonsense knowedge bases)(مثل پروژه “cyc” داگلاس لنات) مثالهای هوش مصنوعی “ناهنجار” هستند و از آنجاییکه بایستی با دست ساخته شوند کاری بسیار دشوار بود.

پایه ی دانش در هوش مصنوعی

زمانیکه دسترسی به کامپیوترهای با حافظه های بزرگ در حدود سال 1970 میلادی فراهم گردید، محققان هر سه سنت ذکر شده شروع به ایجاد دانش برای اپلیکیشن های هوش مصنوعی کردند. این “انقلاب دانشی” منجر به توسعه و استقرار سامانه های خبره (معرفی شده توسط ادوارد فاین باوم) گردید که اولین نرم افزار موفق در زمینه هوش مصنوعی بود. علاوه بر این انقلاب دانشی این موضوع را روشن ساخت که برای بسیاری از اپلیکیشن های ساده هوشمند به حجم بالایی از دانش و اطلاعات نیاز است.

ساب سمبولیک در هوش مصنوعی

در دهه 1980 پیشرفت های زبان سمبلیک هوش مصنوعی به نظر رسید که دچار وقفه شده و بسیاری بر این باور بودند که سیستم های سمبلیک هیچگاه قادر به تظاهر فرآیندهای شناختی انسانی علی الخصوص درک، روباتیک، یادگیری و بازشناخت الگو نخواهند بود. تعدادی از محققان شروع به بررسی کاربرد روش های زبان ساب سمبلیک برای مسائل خاصی از هوش مصنوعی کردند. روش های ساب سمبلیک کاربرد هوش بدون تظاهر ویژه ای از دانش را کنترل می کنند.

بنیادین، گنجانده شده، قرار گرفته، مبتنی بر رفتار یا Nouvelle AI در هوش مصنوعی

محققانی همچون رادنی بروکز از رشته های مرتبط روباتیک، هوش مصنوعی سمبلیک را نپذیرفته و بر مهندسی ساده مسائل که به روبات ها امکان حرکت و تحقیق را می داد، تمرکز کرد. اقدامات این محققان به نقطه نظر غیر سمبلیک (non-symbolic) که توسط نخستین محققان سایبرنتیک در دهه 1950 مطرح شده بود، جانی دوباره بخشیده و استفاده از نظریه کنترل در هوش مصنوعی را باز معرفی کرد. این اقدامات همزمان با توسعه “نظریه مغز گنجانده” در زمینه مرتبط با دانش شناختی بود: ایده ای که بیان می کرد هوش های پیشرفته تر نیازمند نمادهای فردی (همچون حرکت، درک و بینایی) هستند.

هوش محاسباتی و محاسبات نرم در هوش مصنوعی

در اوسط دهه 1980 میلادی توجه به شبکه های عصبی و ارتباط گرایی توسط دیوید راملهارت و دیگران دوباره شکل گرفت. شبکه های عصبی مثالی از محاسبات نرم هستند، و راه حل مسائلی هستند که با قطعیت منطقی نمی توان آنها را حل کرد و نیز جایی کاربرد دارد که راه حلی تقریبی کفایت می کند. دیگر رهیافت های محاسبات نرم در هوش مصنوعی عبارتند از: سیستم های fuzzy (غیردقیق ومبهم) ، محاسبات تکاملی و بسیاری از ابزارهای آماری دیگر. کاربرد محاسبات نرم در هوش مصنوعی همزمان با ظهور رشته هوش محاسباتی مورد مطالعه قرار گرفت.

آمار در هوش مصنوعی

در دهه 1990 محققان هوش مصنوعی ابزارهای ریاضیاتی پخته و کاملی را برای حل مسائل خاص توسعه دادند. این ابزارها به معنای واقعی ابزارهایی علمی بودند که نتایج آنها هم قابل اندازه گیری و هم قابل اعتماد بود. این ابزارها نتیجه موفقیت های پیشین در زمینه هوش مصنوعی بود. علاوه بر این، زبان اشتراکی در ریاضی مجال همکاری با رشته های به ثبات رسیده را به وجود آورد (مانند: ریاضیات، اقتصاد یا تحقیق در عملیات).

استوارت راسل و پیتر نورویگ این حرکت را چیزی کمتر از انقلاب نمی دانند و آن را پیروزی تحقیقات neats (مرتب) در مقابل Scruffiesتحقیقات (ناهنجار) می دانند. منتقدان چنین ابراز می کنند که این تکنیک ها (با چند استثنا) بر روی مسائل ویژه، بیش از حد متمرکز شده و در رسیدن به اهداف بلند مدت هوش عمومی باز مانده اند. در حال حاضر مشاجره بر سر ارتباط و اعتبار رهیافت های آماری در هوش مصنوعی است، که نمونه ای از آن در بخشی از مشاجره بین پیتر نورویگ و نوآم چامسکی نمایان شد.

یکپارچه سازی رهیافت ها در هوش مصنوعی

پارادایم عامل هوشمند در هوش مصنوعی

عامل هوشمند سیستمی است که محیط خود را درک کرده و اقداماتی را انجام دهد که شانس موفقیتش را بالا برد. ساده ترین عامل های هوشمند برنامه هایی هستند که مسائلی خاصی را حل می کنند. عامل های پیچیده تر شامل انسان و سازمان های انسانی هستند (مثل شرکت ها). پارادایم به محققان اجازه مطالعه ایزوله ای مسائل و یافتن راه حل های سودمند و قابل اثبات را می دهد، به گونه ای که تنها موافق یک رهیافت نبوده و همه رهیافت ها را مد نظر قرار دهد. عاملی که یک مسئله به خصوص را حل می کند می تواند از هر رهیافتی که به کارش آید استفاده کند. برخی از عامل ها سمبلیک و منطقی هستند، برخی شبکه های عصبی غیر سمبلیک و نیز برخی دیگر ممکن است از رهیافت های نوین استفاده کنند. علاوه بر این، پارادایم به محققان زبانی را ارائه می دهد که قادر به ایجاد ارتباط با دیگر رشته ها باشند (مثل نظریه تصمیم گیری و اقتصاد) و نیز از مفاهیم عامل انتزاعی بهره گیرند. در دهه 1990 پارادایم عامل هوشمند دربسیاری از موارد پذیرفته شد.

معماری عامل و معماری شناختی در هوش مصنوعی

محققان سیستم هایی را جهت ساخت سامانه های هوشمند (از واکنش عامل های هوشمند در یک سیستم چند عاملی) طراحی کرده اند. سامانه ای با اجزای سمبولیک و غیر سمبولیک یک “سیستم هوشمند هیبرید” (hybrid intelligent system) است و مطالعه چنین سیستمی “یکپارچه سازی سیستم های هوش مصنوعی” (artificial intelligence systems integration) است. یک سیستم کنترل مرتبه ای (hierarchical control system) پلی ما بین هوش مصنوعی ساب سمبولیک و هوش مصنوعی سمبلیک ایجاد می کند. ساب سمبولیک در پایین دست و سمبولیک در بالادست این پل قرار دارد، جایی که وقفه در آن جواز طراحی و مدلینگ دنیا را محدود می کند. “معماری استنتاج” (subsumption architecture) رادنی بروک، پیشنهادی اولیه برای چنین سیستم مرتبه ای بود.

ابزارها در هوش مصنوعی

در طی 50 سال تحقیقات، هوش مصنوعی ابزارهای بسیاری را برای حل سخت ترین مسائل در علوم کامپیوتر ایجاد کرده است. تعدادی از عمومی ترین روش ها در زیر شرح داده شده است:

تحقیق و بهینه سازی در هوش مصنوعی

بسیاری از مسائل در هوش مصنوعی را می توان با بررسی هوشمندانه راه حل های ممکن، حل کرد: استدلال می تواند تبدیل به یک جست و جو شود. بعنوان مثال اثبات منطقی می تواند بعنوان جست و جوی راهی که از کبری و صغری چینی به نتیجه منجر می شود مد نظر قرار گیرد، جایی که هر مرحله از آن یکی از قواعد استنتاج است. الگوریتم های طراحی از طریق درخت های اهداف و ابر اهداف جست و جو می کنند و در تلاش جهت یافتن راهی برای رسیدن به هدف هستند، فرآیندی که آنالیز means-ends نام دارد. الگوریتم های روباتیک برای حرکت دست و پا و به دست گرفتن اشیاء از الگوریتم جست و جوی محلی (local searches) در تشخیص مکان استفاده می کنند. بسیاری از الگوریتم های یادگیری از الگوریتم های جست و جوی مبتنی بر بهینه سازی استفاده می کنند. برای بیشتر مشکلات واقعی جهان، کاوش های ساده و دقیق، کافی نیستند: فضای جست و جو (تعداد مکان هایی که جست و جو می شوند) با سرعت و به صورت نجومی در حال افزایش است. نتیجه ی آن جست و جویی است که سرعت اجرای آن بسیار کند و یا هیچگاه کامل نمی شود. راه حل بسیاری از مسائل استفاده از “تکنیک غیر مستدل” (heuristics) یا قواعد شست انگشتی است که انتخاب های غیر مرتبط با هدف را حذف می کند (هرس درخت جست و جو نامیده می شود). تکنیک غیر مستدل بهترین فرض ها را برای برنامه، در جهت حل مسئله ایجاد می کند. تکنیک غیر مستدل جست و جوی راه حل ها را به فضای نمونه ای کوچک تری محدود می کند.

در دهه 1990 نوعی بسیار متفاوت از جست و جو، بر پایه ی نظریه ریاضیاتی بهینه سازی، رواج پیدا کرد. برای بسیاری از مسائل، ممکن است جست و جو با تعدادی فرض آغاز گردیده و سپس برای این فرض ها، به تدریج اصلاحات تا حدی انجام گیرد که دیگر نتوان اصلاحات بیشتری را انجام داد. این الگوریتم ها ممکن است به عنوان الگوریتم “تپه نوردی” (hill climbing) در نظر گرفته شوند: جست و جو را از نقطه ای تصادفی در دورنما آغاز کرده و سپس با پرش ها یا قدم ها، حدس های خود را به طرف قله تپه حرکت می دهیم (با اصلاحات تدریجی) تا نهایتاً به قله برسیم(جایی که دیگر نمی توان اصلاحی را انجام داد). الگوریتم های تبرید شبیه سازی شده (simulated annealing)، جست و جوی پرتو (beam search) و بهینه سازی تصادفی (random optimization) از دیگر الگوریتم های بهینه سازی هستند.

محاسبات تکاملی از نوعی جست و جوی بهینه بهره می برد. به عنوان مثال ممکن است با جمعیتی از موجودات زنده (فرض ها) کار خود را آغاز کرده و سپس به آنها اجازه جهش و بازترکیبی داده شود، انتخاب طبیعی در هر نسل شایسته ترین آنها را حفظ خواهد کرد (پالایش فرض ها). هوش ازدحامی یا گروهی (swarm intelligence)(مثل کلونی مورچه ها یا بهینه سازی ازدحام ذرات) و الگوریتم های تکاملی (مثل الگوریتم های ژنتیک، برنامه ریزی بیان ژن و برنامه ریزی ژنتیک) از انواع محاسبات تکاملی هستند.

منطق در هوش مصنوعی

منطق برای نمود دانش و حل مسائل استفاده می شود، اما می تواند برای دیگر مسائل نیز به کار گرفته شود. برای مثال الگوریتم satplan روشی برای یادگیریست که از منطق برای طرح ریزی و برنامه ریزی منطق استنتاجی (inductive logic programming) استفاده می کند.

چندین شکل مختلف از منطق در تحقیقات هوش مصنوعی استفاده می شود. منطق گزاره ای یا جمله ای، منطق اظهارات است که می تواند درست یا نادرست باشد. منطق مرتبه اول یا منطق محمولات (first order logic) اجازه استفاده از سورها (quantifiers) و محمول ها (predicates) را داده و قادر به بیان واقعیت اشیاء، ویژگی های آنها و روابط آنها با یکدیگر است. منطق فازی، یک نوع از منطق مرتبه اول است که اجازه می دهد حقیقت یک اظهار به عنوان ارزشی بین “صفر” و “یک” نشان داده شود، به جای آنکه “یک” را به عنوان صحیح و “صفر” را غلط تلقی کند. سیستم های فازی می توانند برای استدلال غیر قطعی استفاده شوند و به طور گسترده ای در سیستم های کنترل محصول (product control system) و صنعتی مدرن استفاده می شوند. منطق ذهنی (subjective logic) عدم قطعیت را در حالتی متفاوت تر و صریح تر از منطق فازی الگو قرار داده است: یک عقیده دو جمله ای در توزیع بتا، باور+ ناباوری+ وعدم قطعیت= 1 را برآورده می کند. با این شیوه جهل و نادانی از اظهارات احتمالی متمایز گردیده که نتیجه ی آن ایجاد عاملی با اعتماد به نفس بالاست.

منطق پیش فرض (default logics)، منطق غیر یکنواخت (non-monotonic logics)، و محدودیت (circumscription) انواعی از منطق هستند که برای کمک به استدلال پیش فرض و مسئله صلاحیت طراحی شده اند. چندین بسط و توسعه از منطق برای مدیریت حوزه های خاصی از دانش طراحی شده است مثل: منطق توصیفی، حساب موقعیت(situation calculus)، حساب رویداد(event calculus) و حساب روان (fluent calculus) (برای تظاهر رویدادها و زمان)؛ حساب اتفاقی (casual calculus)، حساب باور (belief calculus) و منطق موجهات (modal logics).

روش های احتمالی برای استدلال غیر قطعی در هوش مصنوعی

بسیاری از مسائل و مشکلات در زمینه هوش مصنوعی (در استدلال، برنامه ریزی، یادگیری، درک و روباتیک) نیاز به عاملی دارد که با اطلاعات ناکافی یا غیر قطعی نیز کار کند. محققان هوش مصنوعی برای حل این مشکل با بکارگیری روش هایی از نظریه احتمال و اقتصاد، ابزارهای قدرتمندی را ابداع کرده اند.

شبکه های بیزی ابزاری بسیار جامع است که می تواند برای بسیاری از مشکلات استفاده گردد: استدلال (با استفاده از الگوی استنباط بیزی)، یادگیری (با استفاده از الگوریتم امید ریاضی-بیشینه سازی)، برنامه ریزی (با استفاده از شبکه های تصمیم گیری) و درک (با استفاده از شبکه های بیزی پویا). الگوریتم های احتمال می توانند در موارد زیر به کار گرفته شوند: فیلترینگ، پیش بینی، روان کردن و یافتن توضیحات برای جریان داده ها، کمک به سیستم های درک جهت تحلیل فرآیند هایی که در زمان رخ می دهند (برای مثال مدلهای مارکوف پنهان یا فیلترهای کالمن).

“مطلوبیت” مفهومی کلیدی از دانش اقتصاد است: اندازه گیری اینکه یک چیز چقدر برای عامل هوشمند، ارزشمند است. ابزارهای دقیق ریاضی با بهره گیری از نظریه تصمیم گیری، آنالیز تصمیم گیری و نظریه ارزش اطلاعات توسعه یافته اند تا چگونگی انتخاب و برنامه ریزی عامل هوشمند را تحلیل کنند. این ابزارها شامل مدل هایی هم چون؛ فرآیندهای تصمیم گیری مارکوف، شبکه های تصمیم گیری پویا، نظریه بازی و طراحی ساز و کار هستند.

طبقه بندی کننده ها و روش های یادگیری آماری در هوش مصنوعی

ساده ترین کاربردهای هوش مصنوعی به دو نوع تقسیم می شوند: طبقه بندی کننده ها (“اگر درخشید، الماس است”) و کنترل کننده ها (“اگر درخشید، بردارش”). علی رغم آن کنترل کنند ها نیز شرایط را پیش از پی بردن به اقدامات طبقه بندی می کنند، به همین خاطر است که طبقه بندی بخش مرکزی بسیاری از سیستم های هوشمند را تشکیل می دهد. طبقه بندی ها عملیاتی هستند که از الگو های ماشینی برای تعیین نزدیک ترین تطابق استفاده می کنند. تنظیم کننده ها می توانند بر اساس نمونه ها تنظیم شده و برای استفاده در هوش مصنوعی بسیار جذاب شوند. این نمونه ها به عنوان مشاهدات یا الگوها شناخته می شوند. در یادگیری تحت نظارت هر الگو متعلق به یک کلاس از پیش تعریف شده است. یک کلاس می تواند به عنوان تصمیمی که گرفته می شود، دیده شود. تمامی مشاهدات همراه با برچسب کلاسی خود به عنوان یک مجموعه داده شناخته می شوند. زمانیکه یک مشاهده جدید دریافت شد، آن مشاهده بر اساس تجربیات پیشین طبقه بندی می شود.

طبقه بندی کننده از راههای مختلفی می تواند آموزش دیده شود؛ رهیافت های آماری و یادگیری ماشینی بسیاری وجود دارد. بیشترین طبقه بندی کننده های بکار گرفته شده؛ شبکه های عصبی، روش های کرنل مثل ماشین بردار پشتیبانی، الگوریتم نزدیک ترین همسایه های K (k-nearest neighbor algorithm)، مدل ترکیبی گوسین، دسته بندی کننده نایو بیز و درخت تصمیم گیری. عملکرد این طبقه بندی کننده ها در طیف وسیعی از کارها مورد مقایسه قرار گرفته است. عملکرد طبقه بندی کننده ها تا حد زیادی به ویژگی های داده هایی که بایستی طبقه بندی کند دارد. هیچ طبقه بندی کننده مجردی وجود ندارد که در تمام مسائل داده شده، به بهترین شکل عمل کند که این مسئله به قضیه” در جست و جو بهینه سازی از ناهار مجانی خبری نیست” اشاره دارد. تعیین طبقه بندی کننده مناسب برای یک مسئله مفروض، هنوز هم بیشتر از آنکه یک علم باشد، یک هنر است.

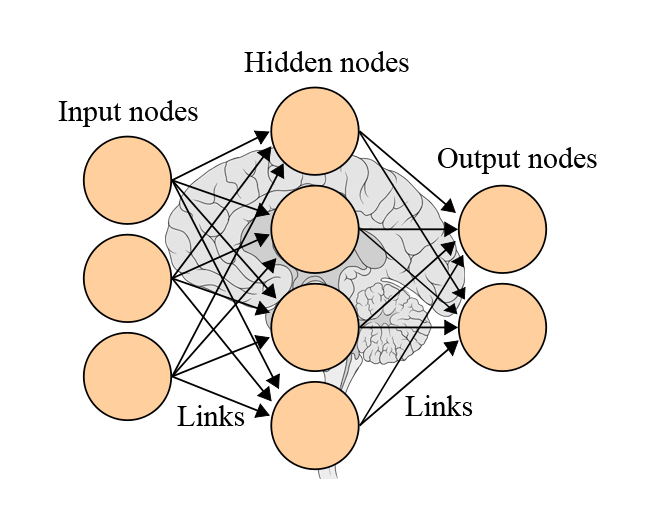

شبکه های عصبی در هوش مصنوعی

شبکه عصبی یک گروه از گره های بهم وصل شده است، همانند شبکه وسیع عصبی در مغز انسان

مطالعه غیر یادگیری شبکه های عصبی مصنوعی در دهه پیش از پایه گذاری تحقیقات هوش مصنوعی با اقدامات والتر پیتز و وارن مک کالو آغاز گردید. فرانک روزنبلات “پرسپترون” را ابداع کرد. پرسپترون همانند مفهوم قدیمی رگرسیون خطی، شبکه یادگیری با یک لایه است. آلکسی گریگورویچ ایواخننکو، تئوکوهونن، استفان گراسبرگ، کونیهیکو فوکوشیما، کریستوف وان درمالسبورگ، دیوید ویلشا، شان ایچی آماری، برنارد ویدرو، جان هاپفیلد و دیگران.

شبکه های غیر مدور یا پیش نگر عصبی (feedforward neural networks)(که در آن سیگنال تنها در یک جهت عبور می کند) و شبکه های عصبی بازگشتی (recurrent neural networks) ( که اجازه بازخورد و حافظه های کوتاه مدت رویدادهای ورودی پیشین را می دهد) از عمده دسته های شبکه ها هستند. پرسپترون ها، پرسپترون های چند لایه و شبکه های پایه شعاعی از جمله معروف ترین شبکه های feedforward هستند.شبکه های عصبی با تکنیک هایی چون نظریه هب، GMDH یا یادگیری رقابتی می توانند برای مشکل کنترل هوشمند (برای روباتیک) و یادگیری به کار برده شوند. امروزه شبکه های عصبی اغلب با الگوریتم های پس انتشار (backpropagation algorithm) آماده می شوند. این الگوریتم از سال 1970 به عنوان حالت معکوس “تمایز خودکار” توسط “سپو لیناینما” منتشر شده و توسط “پال ورباس” به شبکه های عصبی معرفی شد.

حافظه موقتی سلسله مراتبی (hierarchical tempora memory) رهیافتی است که برخی از ویژگی های ساختاری و الگوریتمی نوقشر (neocortex) را الگو قرار می دهد.

شبکه های عصبی پیش نگر عمیق در هوش مصنوعی

یادگیری عمیق در شبکه های عصبی مصنوعی با لایه های زیاد، بسیاری از زیر شاخه های هوش مصنوعی را دگرگون کرده است، زیر شاخه هایی هم چون: بینایی کامپیوتری، بازشناسی گفتار، پردازش زبان طبیعی و …

بر طبق یک بررسی، اصطلاح “یادگیری عمیق” توسط رینا دچتر در سال 1986 به جامعه یادگیری ماشینی معرفی گردیده و پس از اینکه ایگور آیزنبرگ و همکارانش در سال 2000 این عبارت را به شبکه های عصبی مصنوعی معرفی کردند، این عبارت توجه ها را به سمت خود جلب کرد. نخستین پایه و اساس”شبکه های یادگیری عمیق” توسط “آلکسی گریگورویچ ایواخننکو” و “لاپا” در سال 1965 منتشر گردید. این شبکه ها در یک زمان، یک لایه آموزش دیده اند. مقاله سال 1971 ایواخننکو یادگیری یک پرسپترون چندلایه ی پیش نگر عمیق با 8 لایه را شرح داد، که بسیار عمیق تر از شبکه های بعد از آن بود. در سال 2006 مقاله “جفری هینتون” و ” Ruslan Salakhutdinov” شیوه دیگر پیش آموزش “شبکه های عصبی پیش نگر” (feedforward neural networks(FNNs)) چندلایه را معرفی کرد، به این صورت که آموزش یک لایه در یک زمان، به گونه ای که هر لایه به نوبت بصورت یادگیری بی نظارت یک “ماشین بولتزمن محدود” (restricted Boltzmann machine) بوده و سپس با استفاده از الگوریتم پس انتشار با نظارت، تنظیم نهایی گردد. همانند شبکه های عصبی مصنوعی کم عمق، شبکه های عصبی عمیق نیز می توانند از روابط پیچیده غیر خطی الگو برداری کنند. در طی چند سال گذشته، پیشرفت ها در زمینه الگوریتم های یادگیری ماشینی و سخت افزار کامپیوتر منجر به ایجاد روش های کارآمدتر برای آموزش شبکه های عصبی عمیق شده است که لایه های بسیاری از واحدهای پنهان غیر خطی و یک لایه ی خروجی بسیار بزرگ را در بر می گیرد.

یادگیری عمیق اغلب از شبکه های عصبی کانولوشن (convolutional neural networks(CNNs)) استفاده می کند که منشأ آن به نئوکوگنیترون (Neocognitron) معرفی شده توسط کونیهیکو فوکوشیما در سال 1980بر می گردد. در سال 1989 یان لی چان و همکاران الگوریتم پس انتشار را همانند یک معمار به کار گرفتند. در اوایل دهه 2000 میلادی در یک کاربرد صنعتی، شبکه های عصبی کانولوشن حدود 10 تا 20 درصد از تمامی چک نوشته های ایالات متحده را پردازش کردند. از سال 2011 میلادی اجرای سریع شبکه های عصبی کانولوشن بر روی “واحدهای پردازش گرافیکی” (GPUs) بسیاری از رقابت های شناخت الگوهای بصری را برنده شده است.

شبکه های عصبی پیش نگر عمیق (deep feedforward neural networks) همراه با یادگیری تقویتی (reinforcement learning) که در آلفا گو (برنامه deepmind گوگل) به کار گرفته شده بود توانست یک بازیکن حرفه ای در بازی گو را شکست دهد.

شبکه های بازگشتی عمیق در هوش مصنوعی

در اوایل یادگیری عمیق برای ترتیب دادن یادگیری با شبکه های عصبی برگشتی (recurrent neural networks(RNNs)) به کار گرفته شد، که همان کامپیوترهای معمولی هستند و می توانند برنامه های دلخواه را جهت پردازش ترتیب دلخواه ورودی ها، جرا کنند. شبکه های عصبی برگشتی را می توان توسط گرادیان نزولی (gradiant descent) آموزش داد اما از مشکل “شیب محو”(vanishing gradient problem) لطمه می بینند. در سال 1992 نشان داده شد که پیش آموزش بی نظارت دسته ای از شبکه های عصبی برگشتی می تواند سرعت نهایی یادگیری تحت نظارت مشکلات ترتیبی عمیق را افزایش دهد.

در حال حاضر محققان زیادی از انواع یک نوع یادگیری عمیق شبکه های عصبی بازگشتی به نام شبکه “حافظه بلند مدت کوتاه مدت (long short term memory(LSTM)) که توسط هاچ ریتر و شمیدهابر در سال 1997 معرفی گردیده است، استفاده می کنند. LSTM اغلب توسط طبقه بندی پیوند زمانی Connectionist Temporal Classification(CTC))) آموزش داده می شود. در گوگل، مایکروسافت و بایدو این رهیافت تشخیص گفتار(speech recognition) را دگرگون کرد. به عنوان مثال در سال 2015 تشخیص گفتار گوگل یک جهش چشمگیر 49 درصدی را از طریق LSTM آموزش دیده توسط CTC تجربه کرد، که هم اکنون از طریق google voice در دسترس میلیاردها استفاده کننده ی تلفن های هوشمند است. گوگل علاوه بر این از LSTM برای بهبود ترجمه ماشینی، الگوبرداری زبان و پردازش زبان چند زبانه استفاده کرده است. LSTM همراه با CNNs سبب بهبود زیر نویس کردن تصویر و کثرت دیگر اپلیکیشن ها شده است.

نظریه کنترل در هوش مصنوعی

نظریه کنترل (نوه ی سایبرنتیک) کاربردهای بسیار مهمی علی الخصوص در روباتیک دارد.

زبان ها در هوش مصنوعی

محققان هوش مصنوعی چندین زبان تخصصی برای تحقیقات هوش مصنوعی توسعه داده اند که شامل زبان لیسپ و پرولاگ است.

ارزیابی پیشرفت در هوش مصنوعی

در سال 1950، آلن تورینگ روشی کلی برای تست هوش یک عامل پیشنهاد کرد که اکنون به عنوان “تست تورینگ” شناخته می شود. این روش، امکان تست اکثر مشکلات عمده در هوش مصنوعی را فراهم می کند. با این وجود “تست تورینگ” چالشی بسیار دشوار است که تا کنون تمامی عامل ها در آن شکست خورده اند.

علاوه بر این می توان هوش مصنوعی را در مسائل ویژه ای همچون مشکلات کوچک در شیمی، تشخیص دستخط و بازی ها مورد ارزیابی قرار داد. چنین ارزیابی هایی “تست تورینگ خبره در موضوع خاص” (subject matter expert Turing test) نامیده می شوند. مشکلات کوچک تر اهداف قابل دسترس تری ارائه می دهند، و نتایج مثبت روز به روز در حال فزایش هستند.

یک نتیجه از طبقه بندی هوش مصنوعی عبارت است از:

- مطلوب (optimal): اجرای بهتر از این ممکن نیست.

- انسان فوق العاده قوی(strong super-human): بهتر از تمامی انسانها عمل می کند.

- انسان فوق العاده (super-human): از اکثر انسانها بهتر عمل می کند.

- کم تر از انسان (sub-human): از اکثر انسانها بدتر عمل می کند.

به عنوان مثال عملکرد در بازی “چکرز” یا “دام” (draughts) یا در بازی شطرنج super-human و نزدیک به strong super-human است (شطرنج کامپیوتر را ببینید: کامپیوتر در مقابل انسان) و عملکرد در بسیاری از کارهای روزمره (مثل تشخیص چهره یا حرکت در یک اتاق بدون برخورد به چیزی) sub-human می باشد.

یک رهیافت کاملاً متفاوت هوش ماشین ها را از طریق تست هایی که از تعاریف ریاضی توسعه یافته اند، مورد ارزیابی قرار می دهد. نمونه هایی از این نوع ارزیابی ها در اواخر سال های 1990 میلادی تست های هوشمندی را با بهره گیری از اندیشه هایی از “ابهام کولموگروف” (Kolmogrov complexity) و “فشرده سازی داده ها” (data compression) ابداع کردند. دو مزیت عمده از تعاریف ریاضی یکی اطلاق پذیری آنها با هوش غیر انسانی و دیگری عدم نیاز آنها به تست کننده های انسانیست. یک ارزیابی مشتق شده از تست تورینگ “کپچا” یا ” آزمون همگانی کاملاً خودکارشدهی تورینگ برای مجزا کردن انسان و رایانه” است (Completely Automated Public Turing test to tell Computers and Humans Apart(CAPTCHA)). همانطور که نام این تست نشان می دهد، شخص واقعی را از کامپیوتری که خود را جای انسان زده است متمایز می کند. آزمون کپچا مغایر با استاندارد تست تورینگ توسط ماشین اجرا شده و مخاطب آن انسان است، که این مطلب در نقطه مقابل مجری بودن انسان و مخاطب بودن ماشین است. کامپیوتر از کاربر برای تکمیل یک تست ساده سؤال کرده و نمره ای را برای این تست قرار می دهد. کامپیوتر ها قادر به حل مسئله نیستند، از اینرو راه حل درست، نتیجه تست شخص ازمون دهنده شمرده می شود. نوع معمول کپچا تستی است که نیاز به تایپ حروف، اعداد یا نمادهای بهم ریخته دارد که در یک عکس ظاهر شده و برای کامپیوتر ناخواناست.

نمونه ای از یک کپچا

کاربردهای هوش مصنوعی

یک دستیار آنلاین خودکار که در صفحه وب به مشتریان خدمات ارائه می دهد- یکی از ابتدایی ترین کاربردهای هوش مصنوعی

هوش مصنوعی در ارتباط با هر کار فکریست. تکنیک های مدرن هوش مصنوعی گسترده و بسیار زیاد هستند که بتوان اینجا آنها را لیست کرد. اغلب زمانیکه یک تکنیک به استفاده روزمره می رسد، دیگر به عنوان هوش مصنوعی تلقی نمی شود، که این پدیده به عنوان “اثر هوش مصنوعی” (AI effect) شرح داده می شود. وسایل نقلیه خودکار(مثل هواپیماهای بدون سرنشین (پهبادها) یا خودروهای بدون راننده)، تشخیص پزشکی، خلق آثار هنری (مثل اشعار)، اثبات معادلات ریاضی، بازی گیم ها (مثل شطرنج یا گو)، موتورهای جست و جو (مثل موتور جست و جوی گوگل)، دستیاران آنلاین (مثل Siri در IOS)، تشخیص تصویر در عکس ها، فیلتر اسپم و هدف قرار دادن تبلیغات آنلاین از نمودهای عالی هوش مصنوعی هستند.

رقابت ها و جوایز در هوش مصنوعی

تعداد زیادی از رقابت ها و جوایز برای ارتقای تحقیقات در زمینه هوش مصنوعی می باشد. عمده ترین حوزه های ارتقا یافته در این راستا عبارتند از: هوش ماشین عادی، رفتار محاوره ای، کاوش اطلاعات، خودروهای روباتیک، روبات فوتبال و دیگر بازی ها.

پلت فرم ها در هوش مصنوعی

یک پلت فرم (یا پلت فرم محاسباتی) به عنوان”نوعی معمار سخت افزار یا چارچوب نرم افزار (شامل چارچوب های اپلیکیشن ها) تعریف می شود که به نرم افزار اجازه اجرا می دهد.” همانطور که رادنی بروکس سالیان پیش اشاره کرده است، تنها نرم افزار هوش مصنوعی نیست که ویژگی های پلت فرم هوش مصنوعی را تعیین می کند، بلکه بیشتر خود پلت فرم واقعیست که نتایج هوش مصنوعی را تحت تأثیر قرار می دهد، به بیان دیگر در این موضوع ضرورت حل مسائل هوش مصنوعی در پلت فرم های دنیای واقعی بیشتر از محیط ایزوله است.

انواع بسیار زیادی از پلت فرم ها اجازه توسعه به جنبه های مختلفی از هوش مصنوعی را می دهند که از سامانه های خبره (مثل Cyc) گرفته تا چارچوب های یادگیری عمیق و پلت فرم های روبات (مثل رومبا با رابط کاربری باز). پیشرفت های اخیر در ژرفنای “شبکه های عصبی مصنوعی” و “رایانش توزیع شده” منجر به افزایش کتابخانه های نرم افزار شده است که شامل: Deeplearning4j، TensorFlow، Theano و Torch می باشد.

فلسفه و اخلاق در هوش مصنوعی

سه سؤال فلسفی در ارتباط با هوش مصنوعی وجود دارد:

آیا هوش عمومی مصنوعی امکان پذیر است؟ یک ماشین می تواند با هوش خود هر مسئله ای را که انسان قادر به حل آن است، حل نماید؟

آیا ماشین های هوشمند خطرناک هستند؟ چگونه می توانیم مطمئن شویم که ماشین با اخلاق رفتار کرده و نیز طبق اخلاقیات مورد استفاده قرار می گیرند؟

آیا ماشین از ذهن، هوشیاری و حالت های ذهنی دقیقاً همانند بشر، برخوردار است؟ آیا ممکن است ماشین دستخوش احساسات شده و از این رو شایسته حقوق مسلم باشد؟ آیا امکان دارد یک ماشین به طور عمدی صدمه زند؟

محدودیتهای هوش مصنوعی عمومی

آیا یک ماشین می تواند هوشمند باشد؟ می تواند فکر کند؟

میثاق مبادی آداب تورینگ

اگر ماشین بتواند فکر کند ما نیاز به تصمیم گیری نداریم، تنها زمانی نیاز به تصمیم گیری داریم که یک ماشین بتواند همانند یک انسان، هوشمندانه عمل کند. این رویکرد به مسائل فلسفی در ارتباط با هوش مصنوعی، پایه و اساس تست تورینگ را شکل داد.

پیشنهاد کنفرانس دارتموث

“هر جنبه ای از یادگیری یا هر مشخصه دیگری از هوش می تواند چنان موشکافانه شرح داده شود که بتوان ماشینی برای تقلید آن ساخت”. این پنداشت در پیشنهاد کنفرانس سال 1956 دارتموث ثبت شده و اوضاع اکثر تحقیقات کارآمد هوش مصنوعی را نشان داد.

فرضیه سیستم نماد فیزیکی سیمون و نِوِل

“یک سیستم نماد فیزیکی ابزارهای کافی و لازم برای عمل هوش عادی را دارد” نِوِل و سیمون چنین استدلال کردند که هوش از عملکردهای صوری بر پایه ی نمادها تشکیل شده است.

مباحث گودل

کورت گودل، جان لوکاس (در سال 1961) و راجر پنروز (در یک بحث مفصل از سال 1981 به بعد) بر سر اینکه انسانها قابل تنزل به ماشین های تورینگ نیستند، به مباحثه پرداختند. جزئیات مباحث بسیار پیچیده می باشد، با این وجود گوهره و ذات این مباحث از نخستین “قضیه ی ناتمامیت گودل” نشأت می گیرد که همیشه می توان گزاره هایی را خلق کرد که سیستم صوری قادر به اثبات آن نباشد. انسان قادر است حقیقت اظهارات گودل را درک کند. هر برنامه تورینگ می تواند، برای بررسی این گزاره ها، شیوه ی خود را در تبدیل به یک سیستم صوری داشته باشد، و در نتیجه همیشه یک گزاره ی گودل، قابل اشتقاق از برنامه آن باشد، که هیچگاه قادر به کشف آن نباشد. با این وجود به راستی اگر بشر قادر به فهم حقایق ریاضی است، به نظر چنین محدودیتی برای او معنا ندارد. آنچه که بیان شد یک نتیجه کلی است که اگر پذیرفته شود، می توان نشان داد که شبکه های سخت افزار عصبی و کامپیوترهای مبتنی بر پردازش های تصادفی (مثل رهیافت های تبرید) و کامپیوترهای کوانتومی مبتنی بر کیوبیت گره دار (مادامی که فیزیک جدید را شامل نشوند) قابل تبدیل به ماشین های تورینگ هستند. آنچه که همه ی آنها انجام می دهند کم کردن پیچیدگی کارهاست، و مجوز یافتن راه حل برای حل مسائل جدید نیست. راجر پنروز معتقد است که ممکن است فیزیکی جدید در مغز ما، در تقاطع گرانش و مکانیک کوانتومی در مقیاس پلانک وجود داشته باشد. این عقیده اگر پذیرفته شود نفی هوش مصنوعی نیست، در حال که بدان معناست که هوش مصنوعی بایستی بر مبناهای بیولوژیکی و قواعد فیزیک نوین باشد. این بحث مخالفان بسیاری داشته که راجر پنروز به آنها پاسخ داده است و هم اکنون بحثی بسیار بغرنج و پیچیده است. برای درک جزئیات به “فلسفه هوش مصنوعی لوکاس، پنروز و گودل” مراجعه کنید.

بحث مغز مصنوعی

مغز می تواند توسط ماشین ها تقلید شود، و از آنجاییکه مغزها هوشمند هستند، مغزهای تقلید کننده نیز بایستی هوشمند باشند، از این رو ماشین ها می توانند هوشمند باشند. “هانس موراوک”، “ری کرزویل” و دیگر دانشمندان چنین استدلال می کنند که از لحاظ تکنولوژی کپی کردن مستقیم مغز به سخت افزار و نرم افزار شدنی است و در نتیجه چنین شبیه سازی ذاتاً همانند اصل خود خواهد بود.

تاثیر هوش مصنوعی

ماشین ها پیش از این هم هوشمند بودند، منتهی بیننده قادر به تشخیص آن نبود. زمانیکه دیپ بلو در شطرنج گری کاسپاروف را شکست داد، ماشین هوشمندانه عمل می کرد. با این حال، حاضران رفتار هوشمندانه برنامه را با اظهار اینکه “واقعی نیست” نادیده گرفتند؛ بنابراین هوش “واقعی” رفتار هوشمندانه ای است که مردم می توانند آن را انجام دهن و ماشین ها هنوز قادر به انجام آن نیستند! این مطلب به عنوان اثر هوش مصنوعی (AI effect) شناخته می شود:”هوش مصنوعی هر آنچه که هست، هنوز ایجاد نشده است.”

رفتار هوشمند و اخلاقیات ماشین در هوش مصنوعی

یک سیستم هوشمند حداقل بایستی قادر به بازتولید نمود های هوش انسانی باشد. این موضوع بحث بر سر اینکه ماشین از لحاظ اخلاقی با انسانها و دیگر عامل های هوشمند چگونه رفتار کند را بالا برد. این موضوع در کتابی با عنوان “ماشین های اخلاقی”(Moral Machines) نوشته “وندل والاچ” عنوان شد که وی در آن، مفهوم “عامل های اخلاقی مصنوعی” (artificial moral agents (AMA)) را معرفی کرد. AMAs برای والاچ به یک زمینه ی تحقیق در هوش مصنوعی تبدیل گردید، که با دو پرسش اساسی هدایت می گردد: “آیا انسان می خواهد کامپیوترها تصمیمات اخلاقی بگیرند؟” و ” روبات ها واقعاً می توانند اخلاقی باشند؟” اینکه آیا ماشین ها قادر به بروز رفتار اخلاقی برابر، در تقابل با الزاماتی که جامعه برای توسعه ی AMAs قرار داده، هستند…مسئله مورد تمرکز سئوال والاچ نیست.

اخلاق ماشین در هوش مصنوعی

اخلاق ماشین در ارتباط با ارائه ی اساس اخلاقی برای ماشین هاست، یا فرایند یافتن راهی برای حل مسائل اخلاقی که ممکن است ماشین ها با آن مواجه شوند، توانمند ساختن آنها برای عمل کردن در حالتی مسؤلانه و اخلاقی از طریق تصمیم گیری های اخلاقی که خود ماشین ها آن را اتخاذ کنند. نقشه راه این رشته در AAAI Fall 2005 Symposium on Machine Ethics ترسیم شد: ” تحقیق گذشته در مورد ارتباط تکنولوژی و اخلاق، بر استفاده مسؤلانه یا غیر مسؤلانه از تکنولوژی تمرکز کرده است، که این تحقیق توسط چندی از افراد که علاقه مند به موضوع “انسان چگونه بایستی با ماشین ها رفتار کنند” انجام گرفته است. در تمامی زمینه ها، تنها، به استدلال اخلاقی پرداخته است. زمان آن رسیده که یک بُعد اخلاقی، حداقل به برخی از ماشین ها افزوده شود. شناخت پیامدهای اخلاقی که ماشین ها در گیر آن هستند، به اندازه ی توسعه های اخیر و بالقوه در استقلال ماشینی، لازم و ضروری است. در مقایسه با هک کامپیوتر، مسائل مالکیت نرم افزار، مسائل حریم خصوصی و دیگر موضوعات معمول در حیطه ی اخلاقیات کامپیوتر، اخلاق ماشین در ارتباط با رفتار ماشین نسبت به کاربران انسانی و دیگر ماشین هاست. تحقیق در اخلاق ماشین کلید حل نگرانی های سیستم های خودکار است، و نیز می توان چنین ابراز داشت که تصور ماشین های خودکار بدون داشتن بُعد اخلاقی ریشه ی تمام نگرانی ها در زمینه ی ماشین های هوشمند است. علاوه بر این تحقیق در زمینه اخلاق ماشین، ممکن است منجر به شناخت مشکلات نظریه های اخلاقی رایج، گردیده و نیز منجر به تعالی اندیشه ها در حوزه ی اخلاقیات گردد.” اخلاق ماشین گاهاً بعنوان “اصول اخلاق ماشین” (machine morality)، اخلاق محاسباتی (computational ethics) یا اصول اخلاق محاسباتی (computational morality) شناخته می شود. یکی از چشم اندازهای این رشته ی نوظهور در نسخه ی جمع آوری شده “اخلاق ماشین”

گنجانده شده، که از AAAI Fall 2005 Symposium on Machine Ethics نشأت گرفته است.

بدخواه و دوستدار هوش مصنوعی

دانشمند سیاسی به نام چارلز تی روبین معتقد است که هوش مصنوعی نمی تواند “خیر خواه” طراحی یا تظمین شود. وی اظهار کرد”هر خیر خواهی متعالی قابل تشخیص از بدخواهی نیست.” انسانها نباید چنین پندارند که ماشین ها یا روبات ها بخوبی با آنها رفتار خواهند کرد، چرا که منطقی دالّ بر پذیرش موافقت آنها با نظام اخلاقی ما (چیزی که همراه با تکوین ما، تکامل یافته است و هوش مصنوعی سهمی از آن ندارد) وجود ندارد. نرم افزارهای فوق هوشمند ممکن است تصمیم گیرند که از طولانی شدن زندگی انسان حمایت کنند، که در آن صورت متوقف ساختن آنها بسیار دشوار خواهد بود! اخیراً بحث در رابطه با این موضوع به عنوان تهدیدی برای تمدن، انسانها و کره ی زمین درنشریه های آکادمیک آغاز شده است.

استفان هاوکینگ فیزیکدان، بیل گیتز بنیانگذار مایکروسافت و ایلان ماسک بنیانگذار spaceX از اینکه ممکن است هوش مصنوعی به جایی برسد که از کنترل انسان خارج گردد، ابراز نگرانی کردند. “پایانی بر نسل انسان” عنوان نظریه ایست که هاوکینگ آن را بیان کرده است. یک پیشنهاد برای حل این مسئله اینست که اطمینان حاصل گردد نخستین هوش عمومی AI (Friendly AI) خیرخواه است ، آنگاه در آینده قادر به کنترل هوش های عمومی توسعه یافته نیز خواهد بود. اینکه آیا چنین بررسی ممکن است جواب دهد، مورد سؤال است.

رادنی بروکز، محقق پیشرو در زمینه هوش مصنوعی نوشت؛”من فکر میکنم که نگرانی در مورد بد خواه بودن هوش مصنوعی در چند صد سال آینده، اشتباه است. به نظر من نگرانی از یک خطای اساسی در عدم تشخیص تفاوت بین پیشرفت های اخیر در جنبه ی ویژه ای از هوش مصنوعی، و عظمت و پیچیدگی ساخت هوش ارادی –احساسی نشأت میگیرد.”

تنزل ارزش انسانی در مبحث هوش مصنوعی

ژوزف وایزن بام چنین بیان داشت که اپلیکیشن های هوش مصنوعی نمی توانند احساس یک انسان واقعی را تقلید کنند و استفاده از هوش مصنوعی در زمینه های همچون ارائه خدمات به مشتری یا روان درمانی کاری اشتباه است. وایزن بام، محققان هوش مصنوعی (و برخی فلاسفه) را که بسیار علاقه مند بودند مغز انسان را چیزی هم چون یک برنامه کامپیوتری در نظر گیرند، مورد نکوهش قرار داد (وضعی که هم اکنون، محاسبه گرایی شناخته می شود). این نکات از وایزن بام اشاره بر آن دارد که تحقیقات هوش مصنوعی زندگی انسانی را تنزل می دهد.

کاهش در خواست نیروی کار

مارتین فورد، نویسنده “چراغ ها در تونل: اتوماسیون، تکنولوژی پر شتاب و اقتصاد آینده” و دیگران بر این باورند که برنامه های تخصصی هوش مصنوعی، روباتیک و دیگر انواع اتوماسیون، بدین گونه که ماشین ها همانند کارگران و حتی بهتر از آنها اکثر مشاغل روتین و تکراری را انجام میدهند، نهایتاً منجر به بیکاری چشمگیری می شود. فورد پیش بینی کرد که به طور فزاینده ای احتمال ایجاد اتوماسیون در بسیاری از مشاغل مبتنی بر دانش (در یک سری مشاغل سطح پایین) از طریق سامانه های خبره، یادگیری ماشینی و دیگر اپلیکیشن های پیشرفته هوش مصنوعی وجود دارد. اپلیکیشن های مبتنی بر هوش مصنوعی، ممکن است برای تقویت توانایی های کارگران دریایی که دستمزد پایینی دارند بکار گرفته شده، و برون سپاری کارهای مبتنی بر دانش را عملی سازد.

آگاهی ماشین، ادراک و ذهن در هوش مصنوعی

اگر یک سامانه هوش مصنوعی تمام نمادهای کلیدی هوش انسان را اجراکند، آیا چنین سامانه ای می تواند احساسی باشد؟ ممکن است ذهنی داشته باشد که آگاهی را تجربه کند؟ این سؤال در ارتباط نزدیک با مسئله ی فلسفی “ذات آگاهی انسان” قرار داشته و به طور کلی به “مسئله ی دشوار خودآگاهی”(hard problem of consciousness) اشاره دارد.

محاسبه گرایی در هوش مصنوعی

محاسبه گرایی در فلسفه ذهن (philosophy of mind) حالتی است که در آن ذهن یا مغز انسان (یا هر دو) یک سیستم پردازش اطلاعات بوده و فکر کردن نوعی محاسبه است. محاسبه گرایی ابراز می کند که رابطه بین ذهن و جسم همانند یا یکسان با رابطه نرم افزار و سخت افزار است و از اینرو ممکن است راه حلی برای مسئله ی ذهن و بدن (mind-body problem) باشد. این حالت فلسفی از اقدامات محققان هوش مصنوعی و دانشمندان علم شناخت در دهه ی 1960 الهام گرفته و در آغاز توسط فیلسوفان جری فودُر و هیلاری پاتنم مطرح گردید.

نظریه ی هوش مصنوعی قدرتمند

نظریه هوش مصنوعی قدرتمند جان سرل بیان می کند که “کامپیوتری که به طور مناسب با داده های صحیح و خروجی ها برنامه ریزی شده باشد ذهنی دارد که این ذهن، دقیقاً از همان حسی برخوردار است که ذهن انسانی از آن برخوردار است.” جان سرل این اظهار را با استدلال اتاق چینی (Chinese room) خود پاسخ داد، که از ما می خواهد به درون کامپیوتر نگاه کرده و سعی کنیم بدانیم که ذهن کجا ممکن است قرار داشته باشد.

حقوق روبات ها

فرانکشتاین اثر مری شلی یک مسئله کلیدی در اخلاق هوش مصنوعی را مورد بررسی قرار می دهد: اگر ماشینی ساخته شود که از هوش برخوردار باشد آیا این ماشین قادر به احساس هم خواهد بود؟ اگر قادر به احساس باشد، آیا از حقوقی یکسان همانند یک انسان برخوردار خواهد بود؟ این عقیده در تخیّل علمی مدرن نیز پدیدار شده است، مثل فیلمA.I.:Artificial Intelligence که ماشین های شبه انسان، توانایی درک احساسات دارند. گرچه بسیاری از محققان آن را بحثی پیش از موعد می پندارند، هم اکنون این مسئله به عنوان “حقوق روبات ها”(robot rights) شناخته شده و توسط مؤسسه کالیفرنیایی “برای آینده” (Institute for the Future) مورد بررسی قرار گرفته است. این موضوع در مستند پلاگین و دعا، عمیقاً مورد بحث قرار گرفته است.

فوق هوشمند

آیا مرز و حدی برای هوش ماشین ها یا هیبریدهای انسان-ماشین وجود دارد؟ فوق هوشمند (superintelligence, hyperintelligence or superhuman intelligence) یک عامل فرضی است که از هوشی بسیار برتر از ذهن یک انسان با استعداد، برخوردار باشد. “فوق هوشمند” امکان دارد به نوع یا درجه ای از هوش اطلاق گردد که چنین عاملی از آن برخوردار است.

تکینگی تکنولوژی در هوش مصنوعی

اگر تحقیق در زمینه هوش مصنوعی قدرتمند (Strong AI) منجر به تولید نرم افزاری بسیار هوشمند گردد، ممکن است این نرم افزار قادر به برنامه ریزی دوباره خود بوده و خودش را ارتقا دهد. نرم افزار ارتقا یافته اگر در ارتقای خود بهتر عمل کند، منتهی به “خود بهبودی بازگشتی” (recursive self-improvement) می گردد. بدین گونه هوش جدید به طور تصاعدی و حیرت آوری از انسانها پیشی می گیرد. ورنر وینج نویسنده ی علمی-تخیلی این سناریو را “تکینگی” (Singularity) نامید. “تکینگی تکنولوژی” زمانیست که پیشرفت فزاینده در تکنولوژی منجر به تأثیری غیرقابل کنترل گردد، که درآن هوش مصنوعی پا فراتر از استعداد عقلی و کنترل بشر گذاشته و بدین سان به طور ناگهانی تمدن بشری را تغییر داده یا آن را پایان دهد. به این خاطر که توانمندی های چنین هوشی ممکن است غیرقابل درک باشد، “تکینگی تکنولوژی” حادثه ایست که در ورای آن رویدادها غیرقابل پیش بینی و حتی غیر قابل درک هستند.

ری کرزویل با استفاده از قانون مور محاسبه کرده است که قدرت پردازش کامپیوترهای رومیزی در سال 2029 به اندازه مغز انسانها خواهد بود و پیش بینی کرد در سال 2045 “تکینگی” بوقوع خواهد پیوست.

تَرابشریت

یک روز صبح از خواب بیدار می شوید و می بینید مغزتان لوب عملکردی دیگری دارد. به گونه ای مغلوب ناپذیر، این لوب کمکی سؤالات شما را با اطلاعاتی فراتر از قلمرو حافظه ی شما پاسخ می دهد، روش های شدنی و محتمل را پیشنهاد می کند، سؤالاتی را مطرح می کند که به روشن شدن حقایق کمک می کند. شما سریعاً به اندازه ای به لوب جدید اعتماد می کنید که دیگر از چگونگی کارکرد آن شگفت زده نمی شوید. فقط از آن استفاده می کنید، این همان رؤیای هوش مصنوعیست.

مجله بایت، آوریل 1985

هانس موراوج طراح روبات، کوین وارویک سایبرنتیست و ری کرزویل مخترع، پیش بینی کردند که انسانها و ماشین ها به سایبورگ (cyborg=cybernetic+organism) ادغام خواهند شد که موجودی توانمندتر و قدرتمندتر از هر دوی آنهاست. این عقیده که “ترابشریت” نام دارد (اصل و ریشه ی آن از آلدوس هاکسلی و رابرت اتینگر است) به خوبی در تخیلات نشان داده شده است بعنوان مثال؛ “مانگا شبح درون پوسته” (mangaGhost in the Shell) و سری رمان های علمی-تخیلی تله ماسه.

در دهه ی 1980 میلادی سری روبات های جنسی هاجیمه سورایاما، در ژاپن رنگ شده و تولید شدند که شکل حقیقی انسان را با عضلات شبه واقعی و پوستی شفاف نشان می داد، که بعدها در کتاب “زن آدم ماشینی” از آن پیروی شد و نیز مورد استفاده یا تحت تأثیر قرار گرفتن کارگردانانی همچون “جورج لوکاس” شد. سورایاما هیچگاه این روبات ها را بخشی واقعی از طبیعت مطرح نکرد بلکه یک محصول غیر طبیعی که زاییده ی ذهن بشر است، موجودی خیالی در ذهن حتی زمانیکه شکلی واقعی داشت. ادوارد فردکین چنین بیان داشت که هوش مصنوعی سیر بعدی تکامل است”، عقیده ای که نخستین بار توسط ساموئل بولتر تحت عنوان “داروین در میان ماشین ها” پیشنهاد شده و در کتابی با همین نام، توسط جورج دایسون گسترش یافت.

خطر وجودی در هوش مصنوعی

توسعه هوش مصنوعی کامل ممکن است منتج به پایان نسل بشر گردد. یک بار انسانها هوش مصنوعی را توسعه دادند، هوش مصنوعی تقلید کرده و با سرعت فزاینده ای خود را بازطراحی خواهد کرد.

استفان هاوکینگ

یک نگرانی رایج در مورد پیشرفت هوش مصنوعی، ترسی بالقوه است که ممکن است گریبانگیر آدمیزاد گردد. اخیراً این نگرانی بعد از گوشزدهای بزرگ مردانی چون؛ استفان هاوکینگ، بیل گیتس و ایلان ماسک توجه ها را به خود جلب کرد. یک گروه از قدرتمندان معروف تکنولوژی شامل پیترتیل، وب سرویس های آمازون و ایلان ماسک یک میلیارد دلار برای تأسیس یک بنیاد غیرانتفاعی به نام OpenAI هزینه کردند که هدف آن حمایت از توسعه هوش مصنوعی است. عقیده متخصصان در زمینه هوش مصنوعی ترکیبی از نگرانی و عدم نگرانی از فرجام توانمندی فرا انسان گونه ی هوش مصنوعی است، که هر دوی آنها از بخش قابل توجهی برخوردار هستند.

نیک بوستروم در کتاب هوش فوق العاده (Superintelligence) بحثی را راه انداخت، که هوش مصنوعی باعث ایجاد ترس برای انسان خواهد شد. وی اظهار داشت که AI به قدر کافی هوشمند، اگر عملکردهایی را که انتخاب می کند برای رسیدن به هدفی خاص باشد، رفتاری همگرا نشان خواهد داد، بطوریکه منابع را بدست آورد یا خودش را از خاموش شدن محافظت کند. اگر اهداف این عامل هوشمند انسانیت را انعکاس ندهد- یک نمونه اینست که به آن فرمان داده شود تا ارقام عدد پی (pi) را محاسبه کند در اینصورت ممکن است جهت کسب منابع بیشتر و ممانعت از خاموش شدن به انسان آسیب برساند تا نهایتاً به هدف خود برسد.

برای تحقق این خطر، هوش مصنوعی فرضی بایستی بهتر از همه انسانها عمل کرده و بر آنها غلبه کند، که جمع اندکی از کارشناسان امکان وقوع آن را در آینده بعید دانسته و چنین اظهار کرده اند که چنین موردی ارزش تحقیق و بررسی ندارد. دیگر مخالفان نیز چنین بیان کرده اند که از منظر یک هوش مصنوعی، انسان ذاتاً و یا تقابلاً ارزشمند بوده و در کانون توجه قرار دارد.

نگرانی در مورد خطر از جانب هوش مصنوعی منجر به جذب برخی سرمایه گذاری ها و بخشش های بزرگ شده است. در ژانویه سال 2015 ایلان ماسک 10 میلیون دلار به “انستیتو آینده زندگی” (Future of Lif Institute) اهدا کرد تا از تحقیقاتی که برای فهم تصمیم گیری هوش مصنوعی انجام می گیرند، حمایت مالی کند. هدف این انستیتو مدیریت رشد و پیشرفت تکنولوژی، برای رشد عقل و خرد است. ماسک بودجه شرکت های توسعه دهنده هوش مصنوعی، مثل ذهن عمیق گوگل (Google Deep Mind) و Vicarious را تأمین می کند، که هدف وی زیر نظر داشتن سیر تحولی هوش مصنوعیست. او می گوید: “احتمال وجود پیامد بالقوه خطرناکی را میدهم.”

یکی از نگرانی ها، توسعه ی هوش مصنوعی در حوزه ی نظامیست. در حال حاضر بیش از 50 کشور از جمله ایالات متحده امریکا، چین، روسیه و انگلستان در مورد روبات های میدان نبرد تحقیق می کنند. بسیاری از مردم که نگران خطر از جانب هوش مصنوعی فوق العاده هوشمند (superintelligent AI) هستند، خواستار محدودیت استفاده از سربازان مصنوعی هستند.

تصمیم گیری اخلاقی

برای حفظ اخلاق هوش مصنوعی، برخی ها آموزش تکنولوژی های مجهز شده به هوش مصنوعی را پیشنهاد کردند، مثل خودروهای خودگردان (خودروهای بدون راننده)، تا منجر به ارائه تصمیم های اخلاقی توسط خود آنها گردد. برخی ها چنین اظهار می کنند؛ همانگونه که کودکان رفتار را از بزرگترها می آموزند این تکنولوژی ها نیز می توانند آن را از متخصصان علم الاخلاق بیاموزند. ولی باز نظر برخی ها اینست که تکنولوژی های هوشمند قادر به تعیین تمایلات کاربرانشان هستند (تنها راهی که می توان به تمایلات کاربر پی برد) و از این رو برنامه ریزیها در جهت توجه به این تمایلات وگرایش هاست.

هوش مصنوعی در تخیلات

محتوای هوش مصنوعی بُن مایه ی متداول برنامه های علمی تخیلی است. نخستین داستانها به طور ویژه ای حول روبات های هوشمند بود. خود واژه “روبات” سال 1921 توسط کارل چاپک در نمایشنامه کارخانه روبات سازی روسوم (R.U.R) ابداع گردید (RUR: Rossum’s Universal Robots). بعدها ایساک آسیمو نویسنده علمی تخیلی، سه قانون روباتیک را توسعه داد، و متعاقباً در یک سری طولانی از داستانهای روباتها، انها را شرح داد. این قوانین تاکنون کشش هایی را در تحقیقات معتبر هوش مصنوعی بدست آورده اند.

دیگر هوش تخیلی تأثیر گذار “هَل” (HAL) است، کامپیوتری که مسئول سفینه فضایی در فیلم “2001: ادیسه فضایی”است. هم فیلم و هم کتاب این اثر در سال 1968 منتشر شده و نویسنده آن آرتور سی. کلاک است.

تا کنون هوش مصنوعی در فرهنگ عامه و بسیاری از فیلم ها ریشه دوانده است مثلاً:

فیلم “نابودگر” (The Terminator) در سال 1984

فیلم “هوش مصنوعی” (A.I. Artificial Intelligence) در سال 2001

فیلم “او” (Her) در سال 2014

و بسیاری دیگر … .

اگر قبلا در بیان ثبت نام کرده اید لطفا ابتدا وارد شوید، در غیر این صورت می توانید ثبت نام کنید.